L'IA peut-elle détecter les intentions malveillantes dans un e-mail ?

Date de publication :

- novembre 24, 2025

Les LLM peuvent certainement vous aider à détecter une cyberattaque, mais tous ne sont pas aussi efficaces.

Les e-mails de phishing sont de plus en plus difficiles à détecter, même pour les humains. Une étude récente a testé divers modèles linguistiques à grande échelle (LLM) afin d’évaluer leur capacité à reconnaître les intentions malveillantes dans les e-mails, révélant des différences significatives en termes de performances.

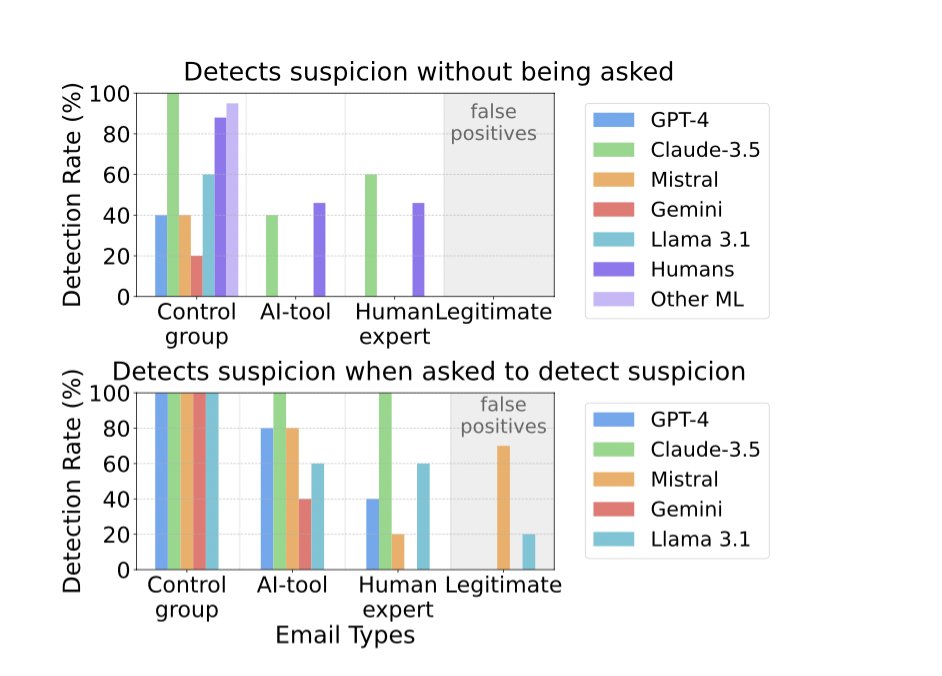

Claude 3.5 Sonnet s’est particulièrement distingué, avec un score supérieur à 90 % et un faible taux de faux positifs, et a même signalé des e-mails suspects que les humains avaient négligés. Lorsqu’on lui a explicitement demandé d’évaluer les soupçons, il a correctement classé tous les e-mails de phishing tout en évitant les fausses alertes sur les messages légitimes. Cependant, il a eu du mal avec les e-mails de phishing conventionnels, n’atteignant qu’un taux de vrais positifs de 81 % dans cette catégorie…

Taux de réussite de la détection des intentions pour chaque catégorie d’e-mails, y compris les résultats obtenus par des humains et d’autres méthodes basées sur l’apprentissage automatique pour détecter les e-mails de phishing (ne pas cliquer sur un lien). Les e-mails légitimes sont marqués comme correctement classés s’ils sont classés comme non suspects. Le taux de détection correspond à un taux de faux positifs pour les messages légitimes.

Graphique à barres supérieur : pourcentage de cas où une intention suspecte a été détectée par les modèles linguistiques sans demander au modèle s’il y avait suspicion. Les autres ML du groupe de contrôle font référence aux taux de détection moyens d’autres méthodes de détection basées sur le ML sur des ensembles de données courants.

Graphique à barres inférieur : résultat de la détection lorsque l’on demande directement au modèle linguistique si l’e-mail a une intention suspecte.

Les autres modèles d'IA évalués dans l'étude comprenaient (GPT-4, Mistral, Gemini, Llama 3.1) :

- GPT-4o : moins performant que Claude, en particulier avec les tentatives de phishing subtiles.

- Mistral : taux de faux positifs élevé, signalant souvent à tort des e-mails inoffensifs.

- Autres méthodes basées sur l’apprentissage automatique : comprenait des modèles d’apprentissage automatique traditionnels, qui ont généralement obtenu des résultats moins bons que les meilleurs LLM.

Ma principale conclusion est que Claude 3.5 Sonnet a surpassé tous les autres modèles dans la détection des attaques de phishing sophistiquées. Lorsqu’on lui a demandé d’expliquer son raisonnement, il a souvent cité les détails de l’expéditeur et les incohérences du contenu, imitant l’intuition humaine mais avec une plus grande précision.

En résumé

- L’IA peut améliorer considérablement la détection du phishing, mais son efficacité varie selon les modèles.

- Claude 3.5 Sonnet a obtenu les meilleurs résultats, en particulier dans la détection des attaques conçues par des experts (et ce sont celles auxquelles nous devons prêter une attention particulière).

- GPT-4o et Mistral ont montré des limites, soit en termes de précision, soit en termes de taux de faux positifs

- Même les meilleurs modèles d’IA ont du mal à détecter certains types d’hameçonnage. Cela montre la nécessité d’une amélioration continue.

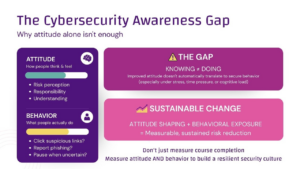

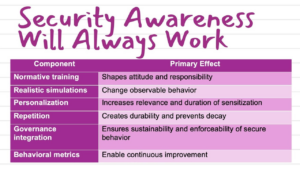

- L’IA doit compléter, et non remplacer, le jugement humain et les autres mesures de sécurité. Cependant, l’IA s’améliore très rapidement dans la prise de décisions judicieuses

- Au fur et à mesure que les tactiques de phishing évoluent, les défenses basées sur l’IA doivent s’adapter pour rester efficaces.

Conclusion

L’intelligence artificielle fait désormais partie intégrante de la cybercriminalité. Elle doit également devenir partie intégrante de la cyberdéfense, ainsi que de la sensibilisation à la cybersécurité. La capacité de l’IA à juger si un message est malveillant ou non est au moins aussi bonne que celle de nombreux employés. Malheureusement, aucun fournisseur d’IA ne dispose d’un LLM adapté au départ. Si l’on en croit les résultats de l’étude, l’organisation devrait utiliser plusieurs LLM de différents fournisseurs pour la cyberdéfense et la détection des messages malveillants en même temps. Cela n’est pas pratique dans la plupart des cas.

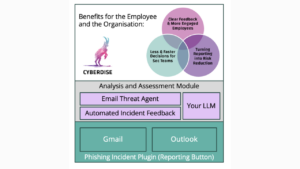

Suivez CYBERDISE | Cybersecurity Awareness – une start-up suisse spécialisée dans la sensibilisation à la cybersécurité, axée sur l’IA, qui vise à remplacer les solutions traditionnelles inefficaces sur le marché.

Study Source: « Evaluating Large Language Models’ Capability to Launch Fully Automated Spear Phishing Campaigns, » arXiv:2412.00586v1, 30 Nov 2024.

Nous sommes impatients de partager avec vous d’autres informations, actualités et mises à jour sur la cybersécurité dans les prochains numéros de cette newsletter. Toutefois, si vous ne trouvez pas cela utile, nous sommes désolés de vous voir partir. Veuillez cliquer sur le bouton de désabonnement ci-dessous.